10.0+41.10 Künstliche Intelligenz

Die folgenden Optionen dienen der Integration von LLMs ("Large Language Models") in QF-Test.

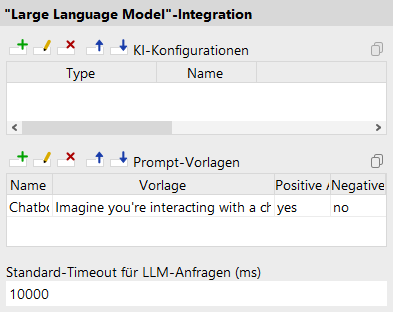

- LLM-Konfigurationen (System)

-

Server Skript-Name:

OPT_LLM_PROVIDERS

In dieser Tabelle können Sie Drittanbieter-LLMs in QF-Test nutzbar machen, zum Beispiel zur Verwendung mit dem Check Text mit KI oder

ai.ask()(siehe Das ai-Modul). Jede Zeile repräsentiert ein konkretes Sprachmodell.Die folgenden Tabellenspalten stehen zur Verfügung:

- Typ

- Der Name des Anbieters bzw. des Typs der API. Falls der von Ihnen benötigte Typ noch nicht zur Verfügung steht, kontaktieren Sie bitte unser Support-Team.

- Name

- Der Name dieser Konfiguration, unter dem sie an anderer Stelle referenziert werden kann.

- URL

-

Die URL, unter der das LLM angesprochen werden kann.

Bitte entnehmen Sie diese Information der Dokumentation des LLM-Anbieters.

Endet üblicherweise mit

/v1oder ähnlich. - API-Schlüssel

- Der API-Schlüssel dient zur Authentifizierung mit dem jeweiligen LLM-Anbieter. Sie erhalten ihn vom LLM-Anbieter.

- Modellname

- Häufig bieten Anbieter verschiedene LLM-Modelle an, z.B. "gpt-4o" oder "gemini-2.0-flash". Die konkret verfügbaren Modell-Namen erfahren Sie beim jeweiligen LLM-Anbieter.

- Prompt-Vorlagen (System)

-

Server Skript-Name:

OPT_LLM_PROMPT_TEMPLATES

In dieser Tabelle können Sie Vorlagen für LLM-Anfragen vorkonfigurieren, zum Beispiel zur Verwendung mit dem Check Text mit KI. Jede Zeile repräsentiert eine konkrete Vorlage.

Die folgenden Tabellenspalten stehen zur Verfügung:

- Name

- Name dieser Vorlage, unter dem sie an anderer Stelle referenziert werden kann.

- Vorlage

-

Der Text-Inhalt der Vorlage, der schließlich an ein LLM geschickt werden kann.

Es stehen folgende Platzhalter zur Verfügung:

-

{{context}}: Zusätzliche anwendungsfallspezifische Angaben, siehe Check-Kontext. -

{{goodCompletions}}: Liste von Beispielergebnissen, die als positiv gewertet werden sollen. -

{{badCompletions}}: Liste von Beispielergebnissen, die als negativ gewertet werden sollen. -

{{completion}}: Das tatsächlich erhaltene Ergebnis, etwa durch einen Check Text mit KI. -

{{positiveResponse}}: Der in "Positive Antwort" konfigurierte Text, um dem Modell zu erklären wie es antworten soll. -

{{negativeResponse}}: Der in "Negative Antwort" konfigurierte Text, um dem Modell zu erklären wie es antworten soll.

-

- Positive Antwort

- Antworttext der als positiv gewertet werden soll, z.B. "ja". Groß-/Kleinschreibung wird nicht berücksichtigt.

- Negative Antwort

- Antworttext der als negativ gewertet werden soll, z.B. "nein". Groß-/Kleinschreibung wird nicht berücksichtigt.

- Standard-Timeout für LLM-Anfragen (ms) (System)

-

Server Skript-Name:

OPT_LLM_REQUEST_TIMEOUT

Der Standard-Timeout für LLM-Anfragen in Millisekunden. Dauert eine Anfrage, etwa im Rahmen eines Check Text mit KI, länger als die angegebene Zeitspanne, wird eine Exception ausgelöst.

- SSL-Verifikation für LLM-Anfragen deaktivieren (System)

-

Server Skript-Name:

OPT_LLM_REQUEST_DISABLE_SSL_VERIFICATION

Für den Fall, dass bei der Kommunikation mit einem LLM SSL-Probleme auftreten, können Sie mit dieser Option die SSL-Verifikation für alle Netzwerkkommunikation mit externen LLM-Modellen deaktivieren.